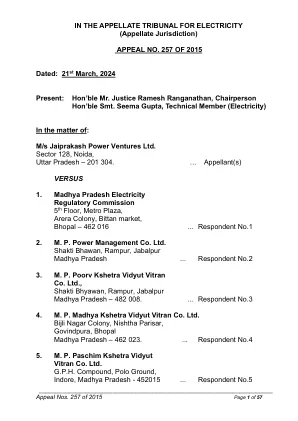

机构名称:

¥ 1.0

摘要 - 面对概括为新颖环境的挑战时,塔迪的机器人策略表现出低于标准的性能。人类纠正反馈是实现这种概括的一种至关重要的指导形式。但是,适应并从在线人类矫正中学习是一项非凡的努力:不仅机器人需要记住人类随着时间的推移的反馈,才能在新环境中检索正确的信息并降低干预率,而且还需要能够响应有关高级人类偏好对低级级别的高度调整的反馈,以响应对低级人士的高度调整。在这项工作中,我们介绍了基于大型语言模型(LLM)的在线校正(DROC)的蒸馏和检索,该系统可以响应语言反馈的任意形式,从校正中提取的可提取知识,以及基于文本和视觉相似性,从而在新颖设置中提高绩效。DROC能够响应一系列在线语言校正,这些校正解决了高级任务计划和低级技能原则中的失败。我们证明DROC有效地将相关信息从知识库中的在线更正顺序提取,并通过新任务或对象实例检索这些知识。DROC优于通过LLMS [1]直接生成机器人代码的其他技术,仅使用第一轮中所需的校正总数的一半,并且两次迭代后几乎不需要校正。我们在我们的项目网站上显示进一步的结果和视频:https://sites.google.com/stanford.edu/droc。

arxiv:2311.10678V2 [CS.RO] 2024年3月21日

主要关键词

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日PDF文件第1页](/bimg/4/4afd21a6f79cd0f6c59ef31f0ea0936a2ea34c24.webp)

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日PDF文件第2页](/bimg/a/a92823323c736a4c9fa79cadcd6d8927a0b67d67.webp)

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日PDF文件第3页](/bimg/7/73761996a1e97fac5332f5408b06686a6da5e572.webp)

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日PDF文件第4页](/bimg/c/c3298cdac747a6cbd00c24b1360971b64fa78f57.webp)

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日PDF文件第5页](/bimg/d/da3fa9839ab3b6c6d85affa6adff76e96cb7c918.webp)

![arxiv:2311.10678V2 [CS.RO] 2024年3月21日](/simg/d/dec77ae97faebdc144858814cd2153c7b85b5b55.webp)

![arxiv:2403.14366v1 [cs.cv] 2024年3月21日](/simg/8/8d320593ada67de300c7ac707880695a5a4b4e4d.webp)

![arxiv:2403.06003v1 [CS.RO] 2024年3月9日](/simg/4/4b4e0cb890dc0eb5c2603aca24782404bf5974a2.webp)

![arxiv:2403.12108V1 [CS.AI] 2024年3月18日](/simg/9/99edd98e89fcbdac6ee748e9e60901730c08c571.webp)

![arxiv:2403.12162v1 [CS.AI] 2024年3月18日](/simg/1/14324854c8cb1d0b1be03ad538fcf657d0de805d.webp)

![arxiv:2303.10780v2 [CS.NE] 2023年3月21日](/simg/7/7b7d55edfb9b26887e4b3f2a6db1ebacdb429654.webp)

![arxiv:2311.10613v3 [Quant-ph] 2024年3月7日](/simg/a/ac72f57c63cc341c42001f022e01852c3496cc94.webp)

![arxiv:2312.14115v2 [CS.RO] 2024年3月20日](/simg/e/e99ee2fdaea7aa8c5ff485da7d65812045754dff.webp)

![arxiv:2311.13273v2 [CS.CL] 2024年1月8日](/simg/3/3ed294e0c1d7cb5f0e98140d864d69d06c84a4cf.webp)

![arxiv:2403.16520v1 [CS.CV] 2024年3月25日](/simg/8/8cb841217ed2eb429029410da59fc3a242748727.webp)

![arxiv:2204.09167V2 [CS.CR] 2024年3月23日](/simg/0/064a8778dbb8621fd55ba2060d123a2d4ceb4db8.webp)

![arxiv:2402.01166v2 [CS.CV] 2024年3月19日](/simg/e/ebc69f9db689b7dd8b3a8bb2751bb41627c75942.webp)

![arxiv:2404.00019v1 [CS.HC] 2024年3月19日](/simg/4/4d6ec2c5822cd74ba0e50cdc16c525cfef1d9813.webp)

![arxiv:2403.01100V1 [CS.CR] 2024年3月2日](/simg/a/a7fccfb5fa86285fb2fe35c99741d6be344a2e79.webp)

![arxiv:2209.00915v3 [CS.CV] 2024年3月24日](/simg/c/c0761a6693346385fec35d9c2df34b28d9f3166c.webp)

![arxiv:2403.05170V1 [CS.CV] 2024年3月8日](/simg/1/12325d057c6e741ba5f8c82c86276e48012ca2de.webp)

![arxiv:2307.09283v8 [CS.CV] 2024年3月14日](/simg/2/231e683527f9f038ee06512ba838618d224b6bd2.webp)

![arxiv:2312.02923v2 [CS.CV] 2024年3月23日](/simg/4/40882b3ffbfd487cf7175f96e2e115dcc1407847.webp)

![arxiv:2403.07692v2 [CS.CV] 2024年3月14日](/simg/0/07e144d34759045ee888c8d72197c74b0cc21d50.webp)

![arxiv:2210.04688V5 [CS.LG] 2024年3月20日](/simg/8/8d11f7fd87768d3dd24ba3062541ede7a346234d.webp)

![arxiv:2403.15600V1 [CS.SE] 2024年3月22日](/simg/f/f211fafbaf6cfa1db8b0d4d88da89fc372b22e3a.webp)

![arxiv:2403.12835v1 [CS.CV] 2024年3月19日](/simg/d/d20844f68974223f91c22f7d76d43b65d4113949.webp)

![arxiv:2303.04376v2 [CS.CV] 2024年2月21日](/simg/c/c08cba40f15bbb2f314c7e7ff6ea1da6df626a12.webp)

![arxiv:2311.17085v2 [CS.CV] 2024年2月19日](/simg/2/2cef09d2f291e154357cd1d57ca70d2de9f797c6.webp)

![arxiv:2311.14552v3 [CS.CV] 2024年10月8日](/simg/0/01bece2b02a718559491f0f4925c190c0dd412dd.webp)

![arxiv:2311.02949v2 [Physics.optics] 2024年3月7日](/simg/a/a7391110e63e2b12ce7f9c506525c993c3a011e9.webp)

![arxiv:2404.00532v1 [CS.CV] 2024年3月31日](/simg/3/3ee124e8a4ce176f01eef2caffa0c7e8d3d8640d.webp)

![arxiv:2401.06312v4 [CS.CV] 29 2024年3月29日](/simg/8/8f626a5a2e27417b245caccf424f2faffb5a7963.webp)

![arxiv:2311.04469v2 [cond-mat.str-el] 2024年3月7日](/simg/3/3eb98e8225336dc53cb27a795ad0469d0e2299f9.webp)